En 2012, un hito tecnológico en el campo de la visión por ordenador tuvo lugar en la nueva edición del ImageNet Large Scale Visual Recognition Challenge. Este desafío buscaba identificar millones de imágenes en mil categorías diferentes, y el equipo liderado por Geoffrey Hinton, junto con Alex Krizhevsky e Ilya Sutskever, presentó un modelo de red neuronal revolucionario: AlexNet.

AlexNet: El punto de inflexión en las redes neuronales convolucionales (CNN)

Lo más impresionante del modelo AlexNet fue su rendimiento superior al de cualquier modelo previo. Lograron reducir el error de reconocimiento de imágenes a tan solo el 15%, una cifra nunca antes alcanzada en ese tipo de competencias. Este éxito catapultó a las redes neuronales convolucionales (CNN) al centro de la investigación en inteligencia artificial (IA), abriendo la puerta a futuros avances en esta tecnología.

La evolución de la IA: Impulsada por grandes volúmenes de datos

La clave detrás de la IA moderna es el acceso a grandes cantidades de datos. Para que los modelos de IA sean capaces de realizar tareas complejas, como el reconocimiento visual, se necesitan grandes volúmenes de información que permitan entrenar estos modelos profundos, que contienen millones de parámetros.

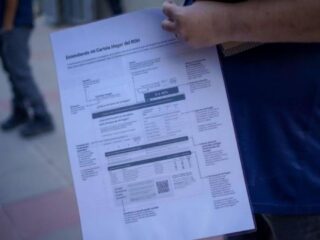

La aparición de redes sociales y plataformas digitales como Facebook, Instagram, YouTube y TikTok generó enormes cantidades de datos, lo que facilitó la recopilación y almacenamiento masivo de esta información. Según Statista, en 2024, la cantidad de datos creados globalmente alcanzó los 149 zettabytes (ZB), y se espera que esta cifra se incremente a 394 ZB en los próximos cinco años.

El papel de las unidades de procesamiento gráfico (GPU)

Desde finales del siglo XX, la industria de los videojuegos ha experimentado un auge significativo, lo que impulsó la demanda de potencia de cálculo para crear gráficos más realistas. La unidad de procesamiento gráfico (GPU) fue desarrollada para optimizar las operaciones matriciales necesarias para manejar los gráficos, que están organizados en grandes matrices de píxeles. Este avance también fue fundamental para el entrenamiento de redes neuronales, ya que los modelos de IA también trabajan con grandes matrices de parámetros.

El uso de GPUs permitió a los investigadores entrenar modelos complejos con cientos de millones de parámetros, lo que resultó en el éxito de redes como AlexNet, que requerían una gran capacidad de procesamiento para trabajar con millones de imágenes.

Complejidad de los modelos y nuevos avances

Con la combinación de la necesidad de modelos más complejos para procesar grandes cantidades de datos y el poder de procesamiento proporcionado por las GPU, el equipo de Geoffrey Hinton fue capaz de desarrollar AlexNet, un modelo que contenía más de 60 millones de parámetros y que usó GPUs para entrenarse con grandes volúmenes de datos. Este avance propició el nacimiento de nuevos modelos de redes profundas como ResNet y VGG, y abrió la puerta a modelos generativos como las redes generativas antagónicas y los autocodificadores variacionales.

Además, comenzaron a surgir modelos capaces de procesar lenguaje natural, dando lugar a los modelos transformer y de atención, que son la base de herramientas de IA como ChatGPT y Gemini. Estos avances están marcando el futuro de la inteligencia artificial y su integración en diversas aplicaciones a nivel mundial.

El futuro de la inteligencia artificial: Modelos generativos y transformadores

La evolución de las redes neuronales profundas ha llevado la inteligencia artificial a nuevas fronteras. Hoy en día, los modelos generativos son capaces de producir imágenes, voces y vídeos casi indistinguibles de las creaciones humanas. Además, los modelos de atención y transformer continúan desempeñando un papel crucial en el desarrollo de modelos de lenguaje que permiten que la IA interactúe de manera más efectiva con los usuarios, transformando la manera en que interactuamos con la tecnología.