A finales del mes pasado, más de mil líderes e investigadores de la tecnología se unieron para redactar una carta, en la que pidieron frenar los acelerados avances en programas de inteligencia artificial como ChatGPT.

Entre los firmantes se encontraron el cofundador de Apple, Steve Wozniak, y el magnate de SpaceX, Tesla y Twitter, Elon Musk, quien paradójicamente acaba de fundar una empresa de IA a la que bautizó como X.AI.

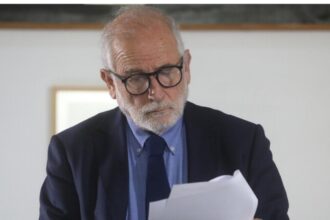

Pero además de ellos, también plasmó su nombre el historiador y filósofo israelí, Yuval Noah Harari, quien ha publicado libros tan aclamados como Sapiens. De animales a dioses: breve historia de la humanidad (Debate, 2014), Homo Deus: breve historia del mañana (Debate, 2014) y 21 lecciones para el siglo XXI (Debate, 2018).

En la carta, los adherentes pidieron una “pausa” en la IA hasta que “estemos seguros de que sus efectos serán positivos y sus riesgos manejables”.

Y precisamente, ese fue el punto que Harari conversó en profundidad en una extensa entrevista con The Telegraph.

Durante la conversación, el filósofo israelí aseguró que esta es “la primera tecnología de la historia que crea historias”, debido a que distintos programas de este tipo tienen la capacidad para elaborar textos, imágenes, videos e incluso música, a partir de ideas que les suministran los usuarios.

“La nueva generación de IA no se limita a difundir los contenidos que producen los humanos. Puede producir el contenido por sí misma”, destacó.

Bajo esta línea, cuestionó: “Trate de imaginar lo que significa vivir en un mundo en el que la mayoría de los textos y melodías, y luego las series de televisión y las imágenes, son creados por una inteligencia no humana. Simplemente no entendemos lo que significa”.

“¿Cuáles podrían ser las consecuencias de que la IA se apodere de la cultura?”.

La semana pasada un semanario alemán compartió una supuesta “entrevista” exclusiva que le hicieron al ex piloto de la Fórmula 1, Michael Schumacher, pero rápidamente se conoció que el artículo había sido elaborado con IA, es decir, no contó realmente con su participación

Aquello desató que sus familiares anunciaran una demanda contra la revista.

Para Harari, casos como ese son solo el comienzo de lo que se podría llegar a hacer con la IA si se utiliza para fines dañinos.

“Puede que incluso te envíen un video hablando, pero no hay ninguna persona de atrás”, insistió, “se trata de una amenaza especialmente grave para las democracias, más que para los regímenes autoritarios, porque las primeras dependen de la conversación pública”.

En este sentido, recalcó que “si la IA se apodera de la conversación, se acabó la democracia”.

Desde su visión, el uso de la IA con fines dañinos también podría ser una nuevo instrumento en beneficio de los sistemas dictatoriales, en caso de que no se adopten medidas previas para restringir sus formas de utilización.

“Un nuevo régimen en el siglo XXI tendrá herramientas mucho más poderosas. Así que las consecuencias podrían ser mucho más desastrosas. Es algo a lo que no sé si la humanidad podrá sobrevivir”.

Un factor crucial en el análisis del filósofo israelí, es que ciertos programas de IA podrían llegar a ser difíciles de controlar si toman “decisiones sobre su propio uso”.

Por ejemplo, representantes de Google anunciaron recientemente que un software que están trabajando aprendió a hablar bengalí de manera instantánea, a pesar de que en un inicio solo le habían entregado “muy pocas indicaciones” en ese idioma.

Harari ve tales casos como un serio problema.

Para disfrutar de los beneficios de esta tecnología considerando sus eventuales riesgos, Harari propuso que se apliquen medidas preventivas como las que se utilizan antes de poner un nuevo remedio a la venta.

“Una compañía farmacéutica no puede lanzar un medicamento al mercado sin pasar antes por un largo proceso de regulación. Es realmente extraño y aterrador que las corporaciones puedan hacerlo con herramientas de IA extremadamente potentes a la esfera pública, sin ninguna medida de seguridad similar”.

Pero, ¿quién tendría que implementar y controlar esas normas?

Para el autor de Sapiens, dicha responsabilidad debe recaer en el sector público y no en las empresas privadas.

“Con todo el debido respeto a Elon Musk y Zuckerberg o a los otros jefes de las grandes empresas tecnológicas, no son elegidos por nadie, no representan a nadie excepto a sus accionistas y no hay razón para confiar en ellos”, cerró.